ハルシネーションとは

ハルシネーションとは、人工知能(AI)が実際には存在しない情報を生成したり、誤ったデータを提示したりする現象を指します。AIが学習したデータに基づいて回答を生成する際、文脈に合わない情報や虚偽の事実を生み出すことがあります。これは、特に自然言語処理(NLP)を活用する生成AIにおいて顕著に見られる問題です。

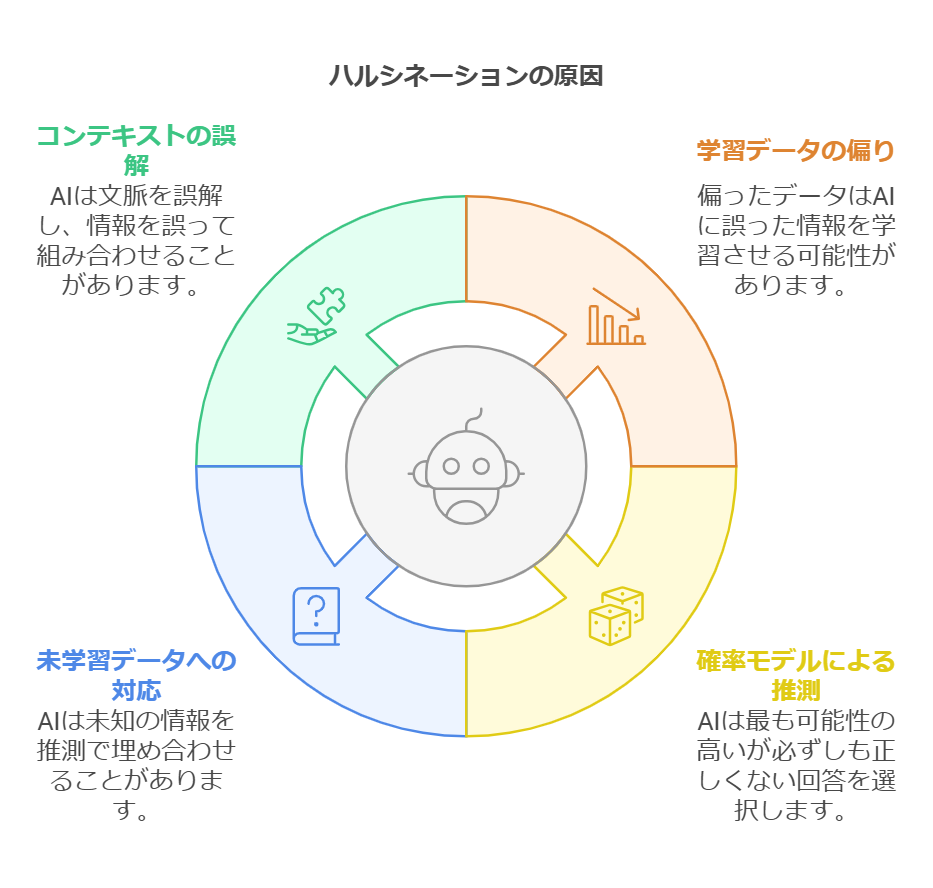

ハルシネーションが発生する原因

ハルシネーションが発生する原因は、以下のようにいくつか考えられます。

-

学習データの偏り AIは過去のデータをもとに学習しますが、そのデータが偏っている場合、誤った情報を生成する可能性があります。

-

確率モデルによる推測 AIは確率的に最適な回答を選ぶ仕組みになっているため、時には事実ではない情報を「もっともらしく」生成してしまいます。

-

未学習のデータに対する対応 AIが学習していない情報について質問された場合、推測によって情報を補完し、結果的に誤った回答を生むことがあります。

-

コンテキストの誤解 AIは文脈を完全に理解できるわけではないため、前後関係を誤認し、事実と異なる情報を組み合わせてしまうことがあります。

ハルシネーションの具体例

ハルシネーションは、さまざまな場面で発生します。

-

偽のニュース記事の生成 AIが存在しない出来事や虚偽のニュースをもっともらしく生成することがあります。

-

誤った医学情報の提供 AIが医学的な質問に対して、誤った治療法や薬の情報を提示する可能性があります。

-

架空の人物や組織の作成 実在しない著名人の発言を作り出したり、架空の会社名を挙げたりすることがあります。

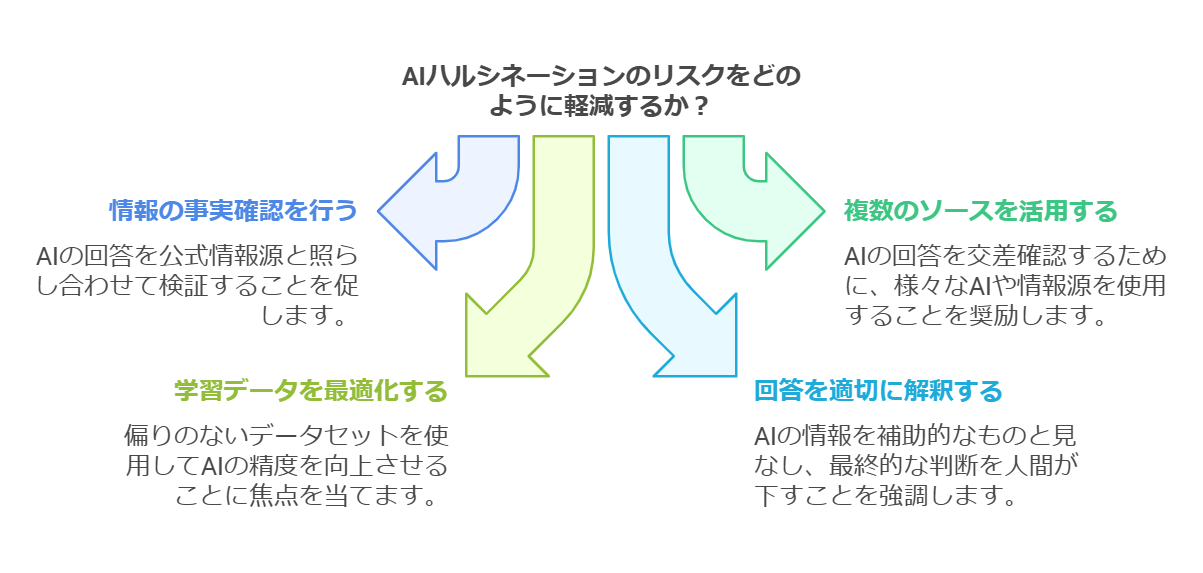

ハルシネーションを防ぐ方法

ハルシネーションを完全に防ぐことは困難ですが、以下の方法でリスクを軽減できます。

-

情報の事実確認を行う AIの回答をそのまま信じず、公式情報源を参照しながら検証することが重要です。

-

複数のソースを活用する 一つのAIの回答に依存せず、複数のAIや情報源を活用して真偽を確かめることが有効です。

-

AIの学習データを最適化する 偏ったデータセットを使用しないよう、AIの学習データを慎重に選定し、精度の向上を図ることが重要です。

-

AIの回答を利用者が適切に解釈する AIが生成する情報はあくまで補助的なものであり、最終的な判断は人間が行うことが大切です。

まとめ

ハルシネーションは、AI技術が発展する中で避けられない問題の一つですが、その影響を理解し、適切な対策を講じることでリスクを最小限に抑えることが可能です。AIの出力を鵜呑みにせず、正確な情報を得るための工夫をすることが、今後のAI活用において重要になってきます。